Teste Kolmogorov-Smirnov

Em estatística, o teste Kolmogorov–Smirnov (também conhecido como teste KS ou teste K–S) é um teste não paramétrico de bondade do ajuste sobre a igualdade de distribuições de probabilidade contínuas e unidimensionais que pode ser usado para comparar uma amostra com uma distribuição de probabilidade de referência (teste K–S uniamostral) ou duas amostras uma com a outra (teste K–S biamostral).[1] Recebe este nome em homenagem aos matemáticos russos Andrei Kolmogorov e Nikolai Smirnov.

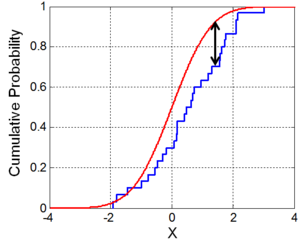

A estatística de Kolmogorov–Smirnov quantifica a distância entre a função distribuição empírica da amostra e a função distribuição acumulada da distribuição de referência ou entre as funções distribuição empírica de duas amostras. A distribuição nula desta estatística é calculada sob a hipótese nula de que a amostra é retirada da distribuição de referência (no caso uniamostral) ou de que as amostras são retiradas da mesma distribuição (no caso biamostral). Em cada caso, as distribuições consideradas sob a hipótese nula são distribuições contínuas, mas não restritas.

O teste K–S biamostral é um dos métodos não paramétricos mais úteis e difundidos para a comparação de duas amostras, já que é sensível a diferenças tanto no local, como na forma das funções distribuição acumulada empírica das duas amostras.[2]

O teste de Kolmogorov–Smirnov pode ser modificado para servir como um teste da qualidade do ajuste. No caso especial do teste da normalidade da distribuição, as amostras são padronizadas e comparadas com uma distribuição normal padrão. Isto equivale a tornar a média e a variância da distribuição de referência iguais aos estimados da amostras, sabendo que usar isto para definir a distribuição de referência específica muda a distribuição nula da estatística. Vários estudos encontraram que, mesmo nesta forma corrigida, o teste é menos potente em avaliar a normalidade do que o teste de Shapiro–Wilk e o teste de Anderson–Darling.[3] Entretanto, estes outros testes também têm suas desvantagens. O teste de Shapiro–Wilk, por exemplo, é conhecido por não funcionar bem em amostras com muitos valores idênticos.

Estatística de Kolmogorov-Smirnov

editarA função distribuição empírica para observações independentes e identicamente distribuídas é definida como

em que é a função indicadora, igual a 1 se e igual a 0 de outro modo.

A estatística de Kolmogorov–Smirnov para uma dada função distribuição acumulada é

em que é o supremo do conjunto de distâncias. Pelo teorema de Glivenko–Cantelli, se a amostra vier da distribuição , então converge a 0 quase certamente no limite quando vai ao infinito. Kolmogorov fortaleceu este resultado ao oferecer efetivamente a razão desta convergência como mostrado abaixo. O Teorema de Donsker oferece um resultado ainda mais forte.

Na prática, a estatística exige um número relativamente grande de pontos de dados para que se rejeite adequadamente a hipótese nula.

Distribuição de Kolmogorov

editarA distribuição de Kolmogorov é a distribuição da variável aleatória

em que é a ponte browniana. A função distribuição acumulada de é dada por[4]

que também pode ser expressa pela função teta de Jacobi . Tanto a forma da estatística do teste de Kolmogorov–Smirnov, como sua distribuição assintótica sob a hipótese nula foram publicadas por Kolmogorov,[5] enquanto uma tabela da distribuição foi publicada por Smirnov.[6] Relações de recorrência para a distribuição da estatística do teste em amostras finitas também foram divulgadas por Kolmogorov.[5]

Sob a hipótese nula de que a amostra vem da distribuição hipotetizada ,

em distribuição, em que é a ponte browniana.

Se for contínua, então, sob a hipótese nula, converge para a distribuição de Kolmogorov, que não depende de . Este resultado também pode ser conhecido como teorema de Kolmogorov.

O teste de Kolmogorov–Smirnov para a qualidade do ajuste é construído pelo uso de valores críticos da distribuição de Kolmogorov.[7] A hipótese nula é rejeitada no nível se

em que é encontrado a partir de

A potência assintótica deste teste é 1.

Teste com parâmetros estimados

editarSe a forma ou os parâmetros de forem determinados a partir dos dados , os valores críticos determinados desta forma são inválidos. Em tais casos, o método de Monte Carlo ou outros métodos podem ser exigidos e as tabelas foram preparadas para alguns casos. Os detalhes para as modificações exigidas para a estatística do teste e para os valores críticos para a distribuição normal e para a distribuição exponencial foram divulgados.[8] Publicações mais recentes incluem a distribuição de Gumbel.[9] O teste de Lillefors representa um caso especial desta questão para a distribuição normal. A transformação do logaritmo pode ajudar a superar casos em que os dados do teste de Kolmogorov parecem não se ajustar ao pressuposto de que veio da distribuição normal.

Distribuição nula discreta

editarO teste de Kolmogorov–Smirnov deve ser adaptado para variáveis discretas.[10] A forma da estatística do teste permanece igual à do caso contínuo, mas o cálculo de seu valor é mais sutil. Isto pode ser visto quando se computa a estatística do teste entre uma distribuição contínua e uma função de etapa que tem uma descontinuidade em . Em outras palavras, o limite , se existir, é diferente de . Assim, quando se computa a estatística

não fica claro como realocar o limite, a não ser que se saiba o valor limitante da distribuição subjacente.

Teste Kolmogorov-Smirnov biamostral

editarO teste Kolmogorov–Smirnov pode também ser usado para testar se duas distribuições de probabilidade unidimensionais subjacentes diferem entre si. Neste caso, a estatística de Kolmogorov–Smirnov é

em que e são as funções distribuição empírica da primeira e da segunda amostra respectivamente e é a função supremo.

A hipótese nula é rejeitada ao nível se

e são os tamanhos da primeira e da segunda amostras respectivamente. O valor de é dado na tabela abaixo para os níveis mais comuns de [11]

| 0.10 | 0.05 | 0.025 | 0.01 | 0.005 | 0.001 | |

| 1.22 | 1.36 | 1.48 | 1.63 | 1.73 | 1.95 |

e, em geral, por

O teste biamostral verifica se as duas amostras de dados vêm da mesma distribuição e não especifica qual é esta distribuição comum, isto é, se é normal ou não normal. Tabelas de valores críticos para este caso também foram publicadas.[8][11] Estes valores críticos têm algo em comum com o teste de Anderson–Darling e o teste qui-quadrado, nomeadamente, o fato de que valores mais altos tendem a ser mais raros.[12]

Limites de confiança para a forma da função distribuição

editarEnquanto o teste Kolmogorov–Smirnov é geralmente usado para testar se uma dada é a distribuição de probabilidade subjacente de , o procedimento pode ser invertido para dar limites de confiança à própria . Caso se escolha um valor crítico da estatística de teste , tal que , então a banda de largura em torno de conterá inteiramente com probabilidade .

Estatística de Kolmogorov–Smirnov em mais de uma dimensão

editarUm teste Kolmogorov–Smirnov de qualidade do ajuste multivariado e livre de distribuição foi proposto por Ana Justel, Daniel Peña e Rubén Zamar em 1997.[13] O teste usa uma estatística construída pelo uso da transformação de Rosenblatt e um algoritmo é usado para a computação no caso bivariado. Um teste aproximado facilmente computado em qualquer dimensão também é apresentado.

A estatística do teste Kolmogorov–Smirnov precisa ser modificada se um teste semelhante for aplicado a dados multivariados. Ela não pode ser aplicada diretamente porque a diferença máxima entre duas funções distribuição acumulada conjuntas geralmente não é igual à diferença máxima de qualquer uma das funções distribuição complementares. Assim, a diferença máxima será diferente, dependendo se ou ou qualquer um dos dois outros arranjos possíveis for usado. Pode-se exigir que o resultado do teste usado não dependa da escolha feita.

Uma abordagem à generalização da estatística de Kolmogorov–Smirnov para dimensões mais elevadas que leva em conta a preocupação acima consiste em comparar as funções distribuição acumulada das duas amostras com todos os ordenamentos possíveis e tomar o maior conjunto das estatísticas K–S resultantes. Em dimensões, o número de ordenamentos é . Uma variação deste tipo foi proposta por J. A. Peacock[14] e outra por G. Fasano e A. Francischini,[15] ambas comparadas por R. H. C. Lopes.[16] Valores críticos para a estatística do teste podem ser obtidos por simulações, mas isto depende da estrutura de dependência da distribuição conjunta.

Ver também

editarReferências

editar- ↑ Daniel, Wayne W. (30 de junho de 2000). Applied Nonparametric Statistics (em inglês). [S.l.]: Duxbury. ISBN 9780534381943

- ↑ Corder, Gregory W.; Foreman, Dale I. (20 de setembro de 2011). Nonparametric Statistics for Non-Statisticians: A Step-by-Step Approach (em inglês). [S.l.]: John Wiley & Sons. ISBN 9781118211250

- ↑ Stephens, M. A. (1 de setembro de 1974). «EDF Statistics for Goodness of Fit and Some Comparisons». Journal of the American Statistical Association. 69 (347): 730–737. ISSN 0162-1459. doi:10.2307/2286009

- ↑ «Evaluating Kolmogorov's Distribution | Marsaglia | Journal of Statistical Software». doi:10.18637/jss.v008.i18. Consultado em 4 de julho de 2017

- ↑ a b Kolmogorov, Andrei (1933). «Sulla determinazione empirica di una legge di distribuzione». Giornale dell'istituto italiano degli attuari. 4: 83-91

- ↑ Smirnov, N. (junho de 1948). «Table for Estimating the Goodness of Fit of Empirical Distributions». The Annals of Mathematical Statistics (em inglês). 19 (2): 279–281. ISSN 0003-4851. doi:10.1214/aoms/1177730256

- ↑ Stephens, M. A. (1 de dezembro de 1979). «Tests of fit for the logistic distribution based on the empirical distribution function». Biometrika. 66 (3): 591–595. ISSN 0006-3444. doi:10.1093/biomet/66.3.591

- ↑ a b Pearson, E. S. and Hartley, H. O., eds. (1972). Biometrika Tables for Statisticians. 2. [S.l.]: Cambridge University Press. pp. 117–123, Tables 54, 55. ISBN 0-521-06937-8

- ↑ Shorack, Galen R.; Wellner, Jon A. (1986). Empirical Processes with Applications to Statistics. [S.l.]: Wiley. p. 239. ISBN 047186725X

- ↑ Arnold, Taylor B.; Emerson, John W. (2011). «Nonparametric Goodness-of-Fit Tests for Discrete Null Distributions» (PDF). The R Journal. 3 (2): 34–39

- ↑ a b c «Critical Values for the Two-sample Kolmogorov-Smirnov test (2-sided)» (PDF). Universidade de Montreal. Consultado em 4 de julho de 2017

- ↑ Mehta, Salil (1 de abril de 2014). Statistics Topics (em inglês). [S.l.]: Createspace Independent Pub. ISBN 9781499273533

- ↑ Justel, Ana; Peña, Daniel; Zamar, Rubén (15 de outubro de 1997). «A multivariate Kolmogorov-Smirnov test of goodness of fit». Statistics & Probability Letters. 35 (3): 251–259. doi:10.1016/s0167-7152(97)00020-5

- ↑ Peacock, J. A. (1 de março de 1983). «Two-dimensional goodness-of-fit testing in astronomy». Monthly Notices of the Royal Astronomical Society. 202 (3): 615–627. ISSN 0035-8711. doi:10.1093/mnras/202.3.615

- ↑ Fasano, G.; Franceschini, A. (1 de março de 1987). «A multidimensional version of the Kolmogorov–Smirnov test». Monthly Notices of the Royal Astronomical Society. 225 (1): 155–170. ISSN 0035-8711. doi:10.1093/mnras/225.1.155

- ↑ Lopes, R.H.C., Reid, I., Hobson, P.R. (23–27 de abril de 2007). The two-dimensional Kolmogorov–Smirnov test (PDF). XI International Workshop on Advanced Computing and Analysis Techniques in Physics Research. Amsterdam, the Netherlands

Ligações externas

editar- Teste Kolmogorov–Smirnov na Encyclopedia of Mathematics (em inglês)

- Breve introdução do Departamento de Física do College of Saint Benedict e Saint John's University de Minnesota (em inglês)

- Breve introdução do Engineering Statistics Handbook (em inglês)

- Calculadora on-line com teste Kolmogorov–Smirnov (em inglês)