Wikipédia:Central de pesquisas/Portal de dados

| Dados brutos | API | Tool Labs | Bibliotecas | Sobre |

A Wikipédia funciona graças a colaboração de diversos ferramentas, usadas de forma integrada, a partir da demanda de edições e acessos. Uma enorme quantidade de dados é gerada a cada hora, novas edições, acesso as páginas, são alguns exemplos de informações estruturadas armazenadas ao longo do funcionamento da Wikipédia.

Os dados brutos aqui falados são: dumps, cópias do banco de dados da Wikipédia e logs de acessos as páginas.

Data Dumps

editarPágina

editar

descrição

editarWMF publica cópias dos bancos de dados da Wikipédia e de todos os outros projetos. Os dados da Wikipédia anglófona são atualizados uma vez ao mês, por conta do seu tamanho, outros projetos menores tem esses dados atualizados com mais frequência.[1]

Conteúdo

editar- Texto e metadados de todas as revisões/edições de todas as páginas, em arquivo XML

- Maior parte das tabelas do banco de dados, em arquivos SQL

- Listas de ligações página-página (ligações de página, ligações de categorias, ligações de imagens)

- Listas de páginas com ligações externas ao projeto (externallinks, iwlinks, langlinks tables)

- Metadados de mídias (imagens, tabela de imagens antigas)

- Informações sobre cada página (página, page_props, tabela restrições de página)

- Títulos de todas as páginas no namespace principal, isso é, todos os artigos (*-all-titles-in-ns0.gz)

- Lista de todas as páginas que são redirecionamentos e sua página alvo (tabela de redirecionamentos).

- Lista de todas que são redirecionamentos e seus respectivos destinos.

- Dados de log, inclui bloqueios, proteção, deleção, material subido (tabela logging)

- Pedaços (interwiki, site_stats, user_groups tables)

- experimental add/change dumps (no moves and deletes + some other limitations) https://wikitech.wikimedia.org/wiki/Dumps/Adds-changes_dumps

- Adds/changes dumps

- Stub-prefixed dumps for some projects which only have header info for pages and revisions without actual content

- Pacotes de mídias para cada projeto, em arquivos distintos que foram enviados ao projeto e arquivos do Commons.

imagens : meta:Database dump#Downloading Images

- Cópia dos arquivos HTML de 2007-2008

- Index of /other/static_html_dumps/

Baixar

editarÉ possível baixar os mais atuais dumps You can download the latest dumps (for the last year) here (http://dumps.wikimedia.org/enwiki/ for English Wikipedia, http://dumps.wikimedia.org/dewiki/ for German Wikipedia, etc).

Arquivos : http://dumps.wikimedia.org/archive/

Espelhos oferecem alternativas para baixar os dados.

Para arquivos de grande tamanho o uso de ferramenta para baixar é recomendado.

Formato dos dados

editarDumps XML desde 2010 são armazenados num formato descrito em Export format( schema ). Esses arquivos estão comprimidos nos formatos bzip2 (.bz2) e .7z.

Dumps em formato SQL são disponibilizados como cópias dos das tabelas do banco, a partir do mysqldump.

Alguns dumps mais antigos estão disponíveis em mais formatos.

Como usar

editarVeja exemplos de importação dos arquivos em um banco de dados MySQL com instruções detalhadas em meta:Data dumps/Import examples

Ferramentas

editarA lista abaixo é de ferramentas para importação e conversão de dados, na sua maior parte arquivos xml. Algumas informações não estão necessariamente atualizadas.

Números de acessos

editarPágina

editarDescrição

editarDados brutos de acessos a partir dos servidores squid, desde de 2007.

Conteúdo

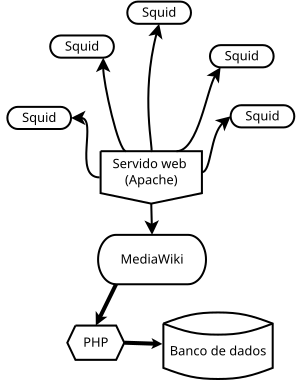

editarCada requisição de página vai para um dos servidores cache Wikimedia, chamados squids. O nome do projeto, o tamanho da página requisitada e o título da página requisitada são armazenados a cada hora. Estatísticas para os projetos em inglês existem desde 2007, outros idiomas vieram a partir de 2008.

Arquivos cujos nomes começam com "projectcount" contém apenas o total de acessos por projeto por hora. Nota: Esses não são acessos únicos e nomes mudados são contados separadamente.

Baixar

editarFormato dos dados

editarOrdem dos dados:

[Projeto] [Nome_do_artigo] [Número_de_requisições] [Tamanho em bytes do conteúdo requisitados]

onde Projeto está no formato languagem.projeto usando as abreviações descritas aqui.

Exemplos:

fr.b Special:Recherche/Achille_Baraguey_d%5C%27Hilliers 1 624

significa que a página com o título Achille_Baraguey_d%5C%27Hilliers do Wikilivros em francês, foi acessada uma vez na última hora e o tamanho do conteúdo é 624, em bytes.

en Main_Page 242332 4737756101

Vemos que a página principal da Wikipédia em inglês foi requisitada mais de 240 mil vezes no intervalo de uma hora.

Dados em formato JSON também estão disponíveis no site http://stats.grok.se/.

Ferramentas existentes

editarstats grok

editarÉ possível navegar interativamente pelas estatísticas de acessos e conseguir esses dados em formato JSON, a partir de http://stats.grok.se/.

Mantenedor

editarhttp://stats.grok.se/ é mantido por User:Henrik

Projetos de pesquisa que usam esses dados

editar- Early Prediction of Movie Box Office Success based on Wikipedia Activity Big Data combines the page view statistics for articles on movies from the raw page view dumps with the editorial activity data from the toolserver database to predict the financial success of movies

- Wikipedia-Zugriffszahlen bestätigen Second-Screen-Trend(in German) studies how the TV schedule influences Wikipedia pageviews

- Mais exemplos

Referências

- ↑ Checar quanto tempo leva para atualizar os dados da WP:PT